Автор фото Люк Чессер с сайта unsplash.com.

Падение органического трафика сайта – как решить

Как проверить трафик сайта

Яндекс.Метрика

Google Analytics

Технические проблемы

Ошибки внутренней оптимизации

Санкции поисковых систем

Обновление поисковых алгоритмов

Внутренняя и внешняя ссылочная оптимизация

Ухудшение поведенческих факторов

Сезонность товара или услуги

Поменялся интент запроса

Конкурентность

Подводим итог

Снизился трафик – это проблема для продаж. Органический трафик может снизиться из-за обновлений алгоритмов, технических проблем, плохой оптимизации страницы, потери качественных обратных ссылок, активности конкурентов, некачественного/дублированного контента или штрафов. Мы расскажем о причинах падения трафика и способах решения проблем. За динамикой трафика нужно наблюдать системно, чтобы вовремя замечать и исправлять возможные сбои.

Как проверить трафик сайта

Падение трафика всегда показывает проблемы на сайте. Люди перестают искать ресурс или не могут его обнаружить в поиске. Для бизнеса это приводит к печальным последствиям – падению выручки, сокращению спроса.

Анализ падения трафика даст возможность уточнить, насколько просел трафик. Анализируя причины и следствия падения трафика, компания получает ценную информацию о поведении в Интернете, чтобы оптимизировать цифровые стратегии и максимизировать охват. Лучший (и самый быстрый) способ понять, что случилось с трафиком, — это просмотреть отчет об эффективности в Яндекс Метрике, Google Analytics.

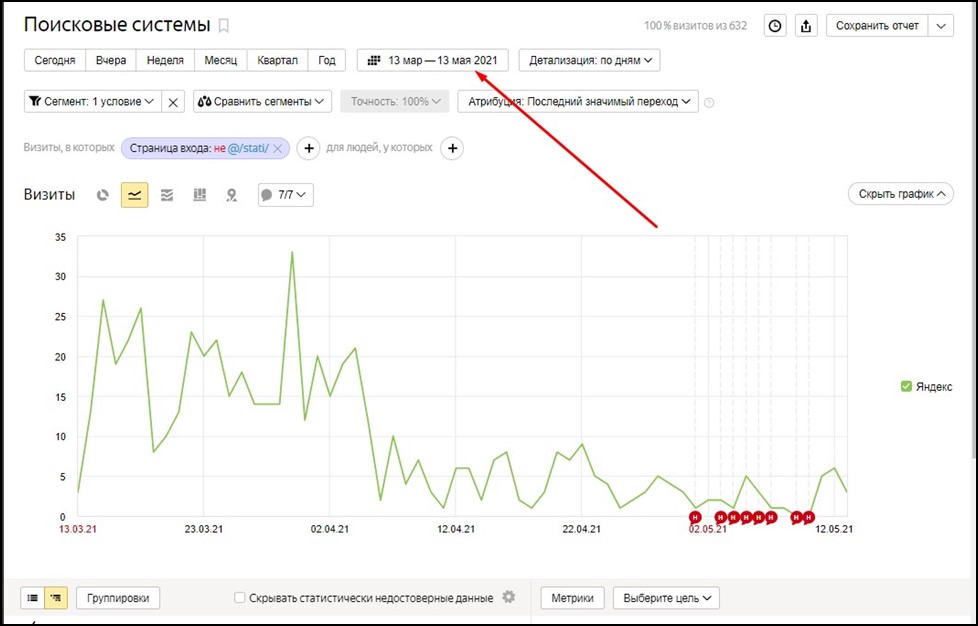

Яндекс.Метрика

Яндекс.Метрика — функциональный инструмент веб-аналитики от Яндекс. С помощью этого бесплатного сервиса вы сможете анализировать поведение пользователей на платформе, посещаемость сайта, сравнивать показатели трафика для разных сегментов. Такой сервис, как Яндекс.Метрика, в основном нужен коммерческим сайтам, поскольку позволяет качественно оценить эффективность рекламы, удобство использования сайта, источники трафика и конверсии. После установки счетчика и настройки всех параметров данные о посещениях сайта будут переданы в отчеты, которые будут отображаться на панели «Сводка». Отчеты делятся на стандартные (самые важные аналитические данные), мои отчеты (отчеты, настроенные вручную для целей), избранные (отчеты, добавляемые на месте), запланированные отчеты (отчеты, формируемые к нужным датам).

На основе анализа, сформулированного в отчетах, можно скорректировать SEO сайта: продвижение, оптимизацию рекламных кампаний, коррекцию дизайна страниц, удобство использования сайта, навигацию и контент.

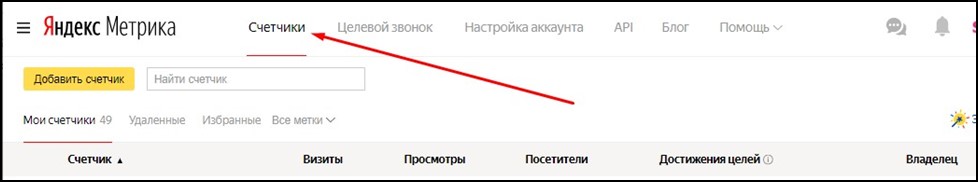

Проверка делается следующим образом:

- Войти в раздел «счетчики».

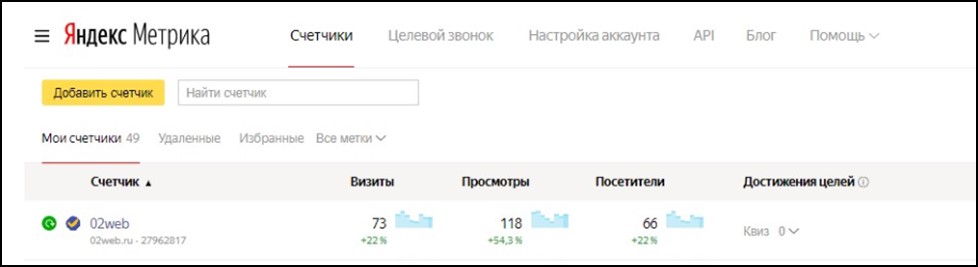

2.Выбрать счетчик для проверки.

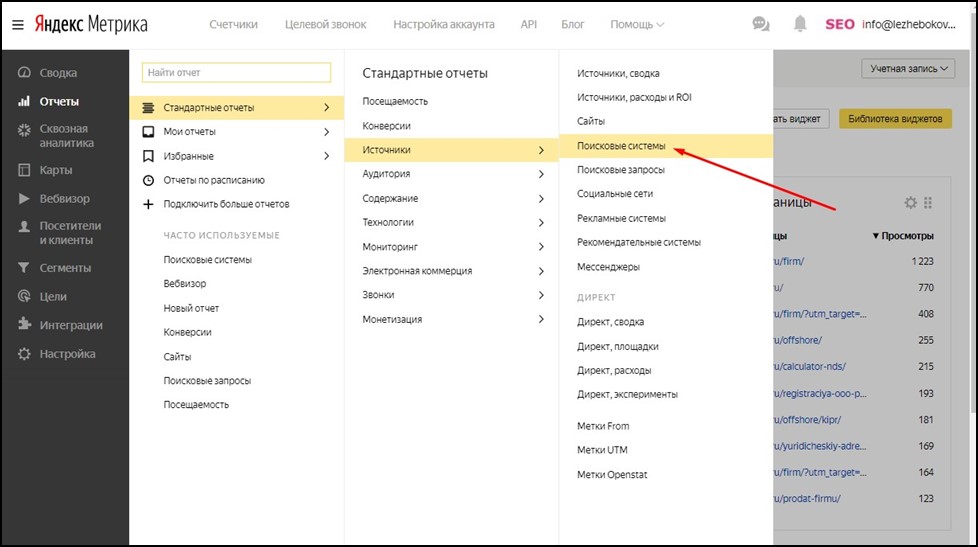

3.В левой колонке выбрать «Отчеты-Стандартные отчеты – Источники-Поисковые системы».

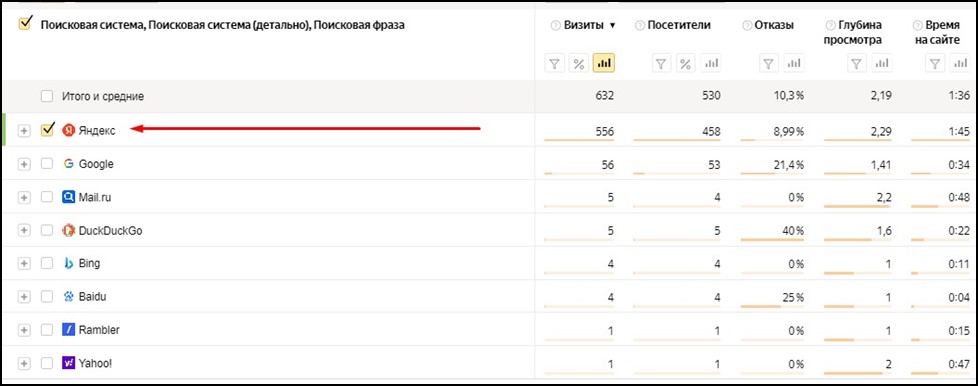

- Выбрать поисковую систему.

5.Выбрать период для анализа.

Проанализировать полученный график и выявить возможные причины падения трафика.

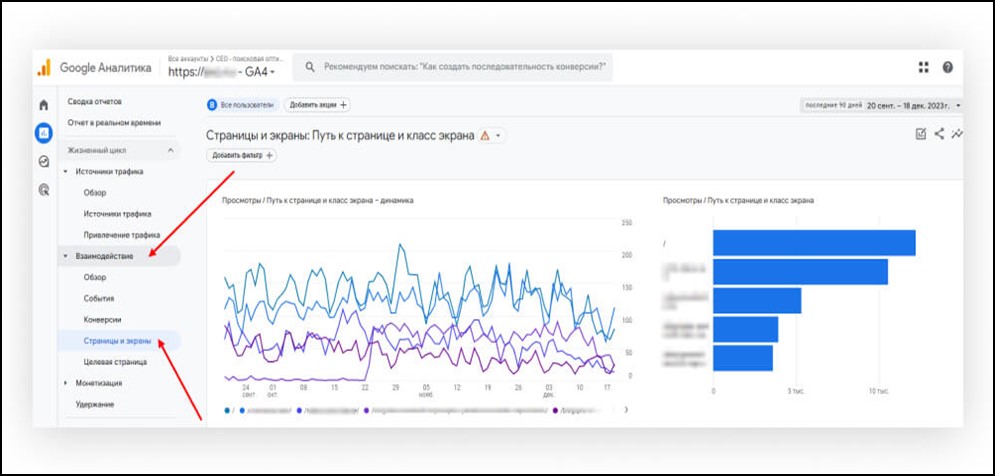

Google Analytics

После входа в сервис, перейти на вкладку «Взаимодействие» → «Страницы и экраны». Выбрать диапазон дат и сравнить с предшествующим периодом. Отчет покажет сведения о посещаемости страниц.

Далее рассмотрим возможные технические проблемы, влияющие на падение трафика и способы их решения.

Технические проблемы

Технические проблемы не позволяют поисковым системам сканировать, индексировать и, в конечном итоге, ранжировать страницы в результатах поиска. Обычно это приводит к снижению трафика по всему сайту. Причины падения трафика нужно отслеживать регулярно. Если сайт в настоящее время испытывает падение из-за технических проблем, на это могут повлиять несколько факторов:

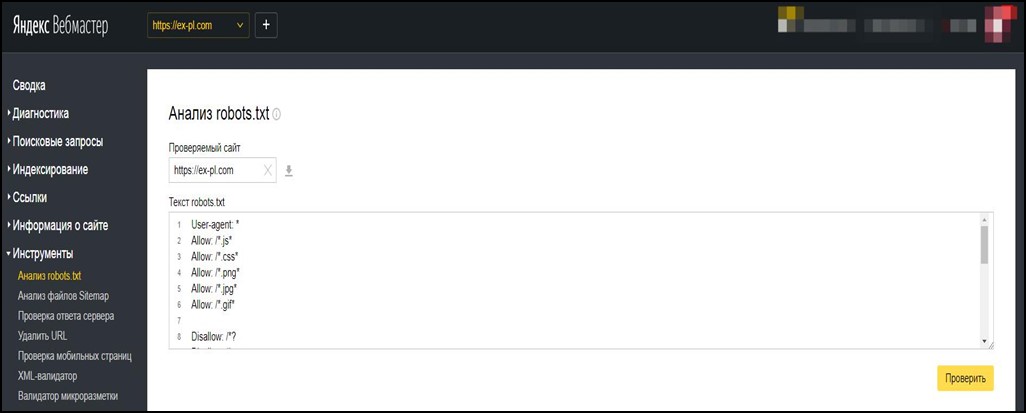

- Запрет индекса в robots.txt

Robots.txt – это короткий текстовый файл, который указывает веб-сканерам (например, роботу Googlebot), что им разрешено сканировать на сайте. С точки зрения SEO, robots.txt помогает сканировать наиболее важные страницы и не позволяет ботам посещать неважные страницы. Поисковые системы обращаются к robots.txt с целью выявления страниц для индексации.

Запрет и разрешение индексации страниц проводят с помощью директив Disallow/Allow. Например:

Disallow: /

Allow: /articles.

Закрыт весь сайт, кроме раздела статей.

Проверку наличия и корректности файла делают в Яндекс. Вебмастере: в адресную строку вводится информация – адрес сайта/robots.txt. При отсутствии robots.txt будет показана ошибка 404 или пустой фон. Проанализировать файл можно через вкладку “Инструменты -> Анализ robots.txt.

В поле “Разрешены ли URL?” вводят адреса страниц и нажимают «проверить».

Такую же операцию проводят в Google Search Console.

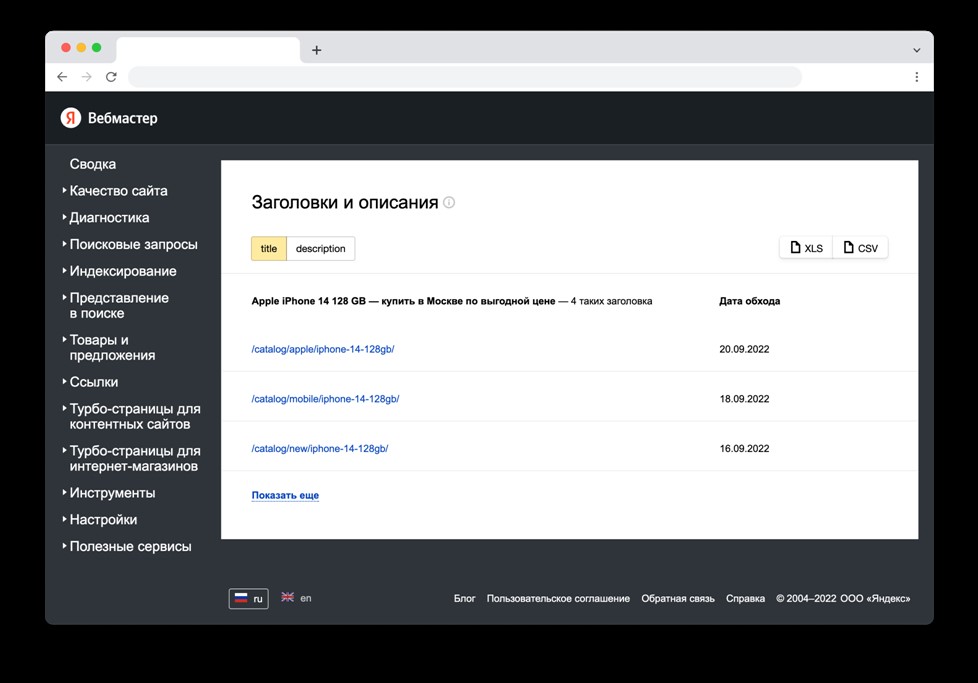

- Технические дубли

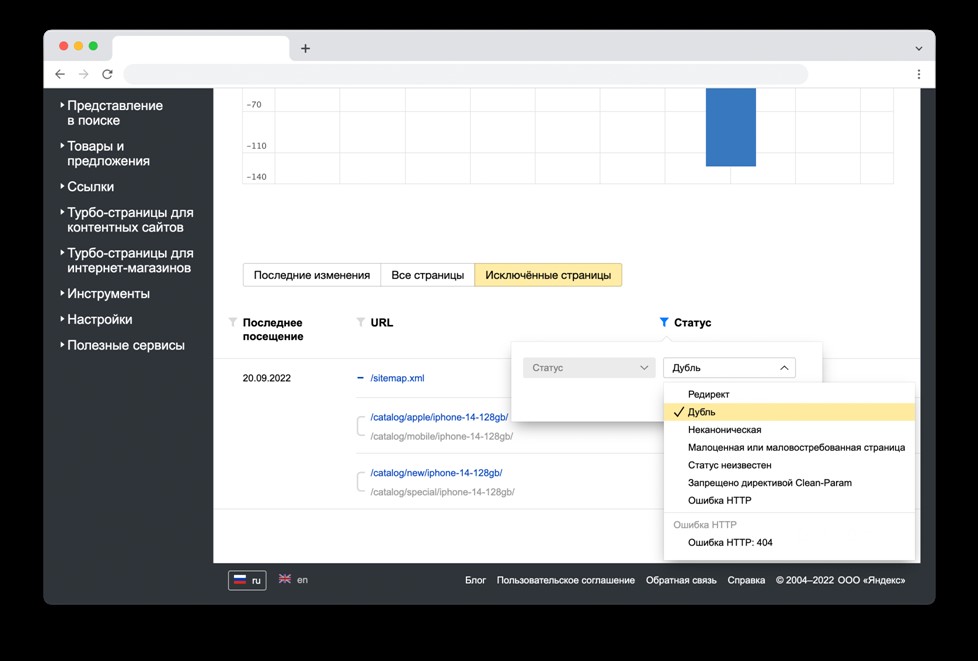

Технические дубли появляются, когда страницы открываются по разным адресам (например, забыли убрать из индексации страницы прежнего сайта с протоколом http), когда один и тот же товар размещен в разных категориях, есть региональные версии сайта. Причинами появления является человеческий фактор или особенности CMS. Проверить наличие дублей помогут Яндекс.Вебмастер, Google Search Console. В Вебмастере зайти в раздел Индексирование -> Заголовки и описания. Отчет покажет все URL с одинаковым текстом в тегах <title> и <description>:

В разделе Индексирование -> Страницы в поиске показаны страницы, удаленные из поиска по причине дублирования.

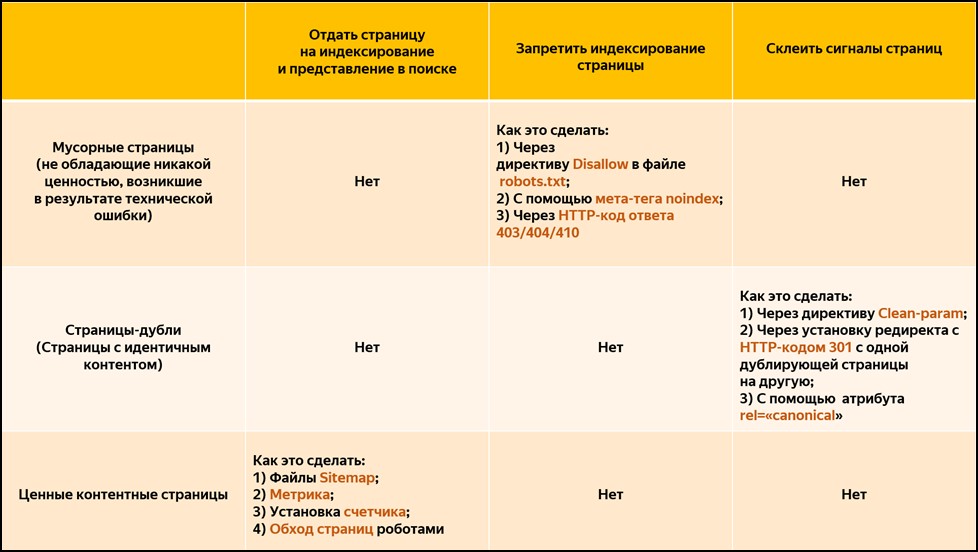

Обнаруженные дубли нужно удалить способами, предложенными Вебмастером:

Чтобы предотвратить появление новых дублей, замедляющих трафик сайта, проверку проводят периодически.

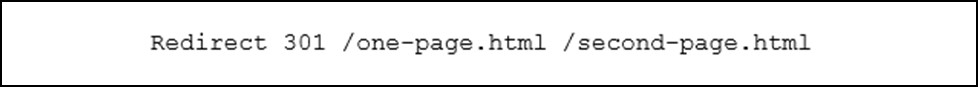

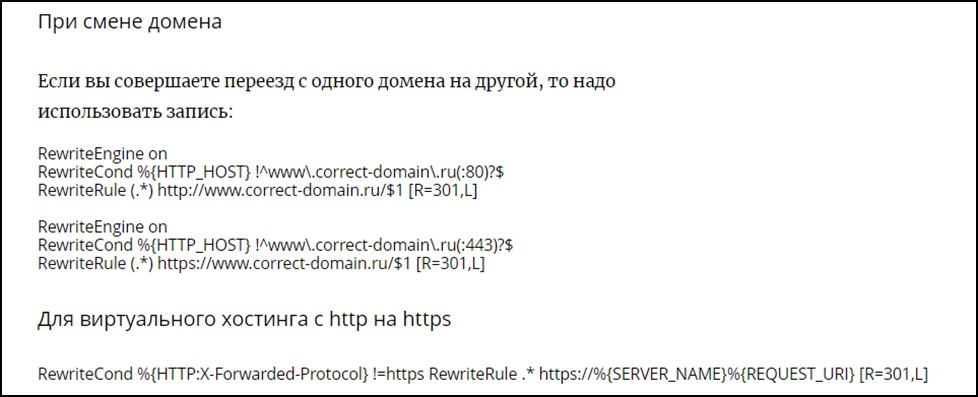

- Не настроен 301 редирект

Настройки часто слетают, когда сайт переезжает на другой домен. Проверка редиректа производится вручную – при переходе с одной страницы на другую должен быть корректный адрес, либо массово с помощью специального софта (Screaming Frog SEO, Redirect Checker, PR-CY Info). Перенастроить 301 редирект можно через htaccess (конфигурационный файл веб-сервера Apache, в файловом менеджере хостинга). Перенаправить с одной страницы на другую можно следующим образом:

При массовой настройке после переезда:

Проверку также следует проводить регулярно, чтобы исключить потери трафика.

- Наличие большого количества битых ссылок

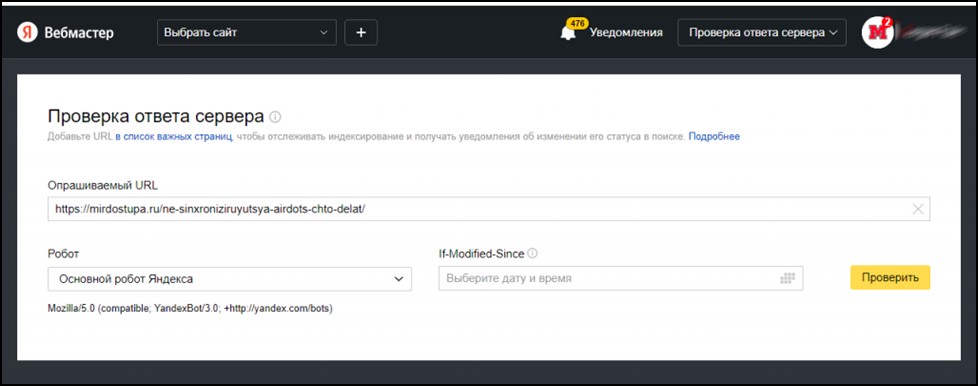

Множество 404 страниц на сайте негативно влияет на поведенческие факторы, поэтому проблему рекомендуется решать как можно скорее. Проверку битых ссылок делают с помощью Яндекс. Вебмастера, инструмента «Проверка ответа сервера». Следует указать URL и тип робота:

Проверку делают и в других сервисах, например Checkmy и Labrika. Для исправления проблемы делают корректное перенаправление на нужную страницу с помощью редиректа 301 или восстанавливают содержимое утраченной страницы.

- Скорость загрузки сайта

Поисковики отдают предпочтение ресурсам с быстрой загрузкой. Пользователи покидают медленно загружающиеся страницы. Проверить скорость загрузки страницы помогут Sitechecker, Google Page Speed Insights. Для увеличения скорости загрузки следует уменьшить имеющиеся изображения, оптимизировать шрифты до наиболее простых, воспользоваться инструментами Яндекс. Турбо страницы, Google – Accelerated Mobile Pages.

- Вирусы

Вирусы на сайте появляются из-за старых плагинов, проблемах в CMS, слабой защиты сайта. Google и Яндекс проверяют сайты на наличие вредоносного ПО и удаляют зараженные сайты из результатов поиска. Эта практика известна как черный список. Поисковые системы также размещают предупреждение на сайтах, занесенных в черный список, чтобы защитить посетителей от вредоносного контента. Предупреждение сообщает посетителям, что сайт заражен, и не позволяет им войти. Это приведет к падению трафика и доверия к сайту.

Проверку сайта проводят с помощью Dr.Web, PR-CY. Для улучшения защиты сайта устанавливают антивирусные программы, своевременно обновляют плагины.

- Изменение на сайте

Изменения на сайте, такие как удаление страниц, изменение структуры сайта и редизайн сайта – могут повлечь за собой потерю трафика. Поисковым системам требуется от 2 недель до 3 месяцев, чтобы восстановить получение трафика. Подробнее об изменениях на сайте мы рассказали в статье.

Ошибки внутренней оптимизации

Падение посещаемости сайта происходит из-за ошибок внутренней оптимизации, таких как:

- Смысловые дубли

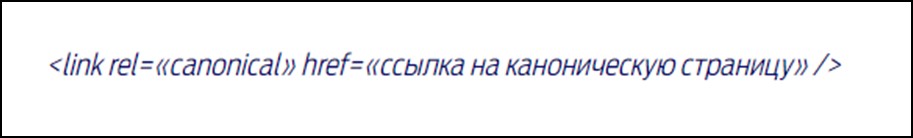

Дубли частично одинаковы или по смыслу повторяют контент на других страницах. Выше мы рассказали, как их найти и устранить. Поисковики наказывают за дубли контента внутри сайта, без настройки канонических страниц снижением трафика. Для корректной настройки применяют метатег с атрибутом rel=«canonical». Он покажет приоритетную для индексации страницу. Для настройки в коде между тегами <head> и </head> страницы-дубля применяют метатег Link с атрибутом rel=«canonical»:

- Неуникальный контент

Уникальность контента является обязательной. В противном случае можно попасть под фильтры поисковых систем. В Гугл за малополезный, неуникальный контент сайт попадает под фильтр «Панда», в Яндекс под «Баден баден». Убрать сайт из-под санкций можно только через удаление дублей, копипаста.

- Дубли мета-тегов

Title – это элемент HTML, определяющий заголовок страницы. Играет важную роль в предоставлении читателям и сканерам поисковых систем краткого и точного описания содержания страницы. Description – это атрибут HTML, который предоставляет краткое описание содержимого страницы. Он появляется в виде фрагмента под тегом заголовка в поисковой выдаче и помогает пользователям понять, чего ожидать от страницы, прежде чем нажать на нее.

Дублирование мета тегов в тексте отрицательно влияет на индексацию, они рассматриваются как спам. Дубли нужно удалить.

- Избыток рекламы

Избыток рекламы приводит к пессимизации. Поисковик негативно реагирует на навязчивую, повторяющуюся рекламу.

- Неудобная структура

Юзабилити, неудобная навигация, неочевидные или мелкие детали дизайна, которые мешают или портят впечатление о сайте – это все является важными факторами, которые могут повлечь за собой понижение в поисковой выдачи, а в худшем случае наложение санкций.

- Переспам ключевых запросов

Чрезмерное использование ключевых слов может снизить качество контента, ухудшить взаимодействие с пользователем, привести к санкциям поисковых систем. Ключи могут повторяться в тексте, подписях к изображениям и мета тегах. В тексте переспам приводит к плохой читаемости, отказам и падению посещаемости.

Проверку переспама проводят с помощью сервисов Text.ru, Адвего и приводят текст в соответствие с рекомендуемыми параметрами.

Санкции поисковых систем

Если упал трафик на сайте, надо проверить наличие санкций поисковых систем.

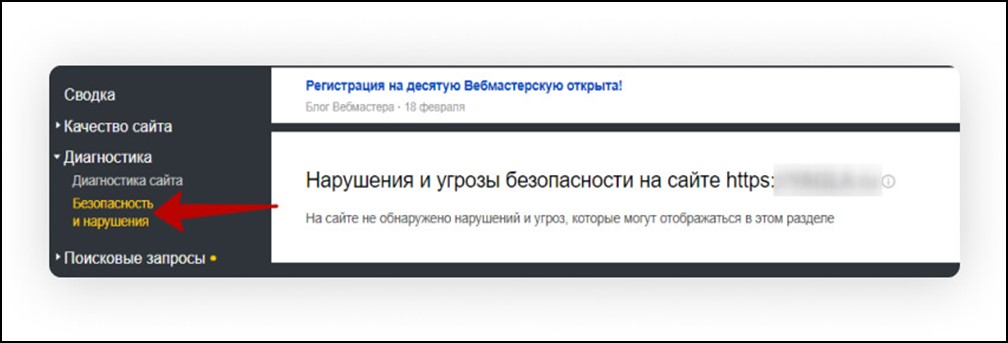

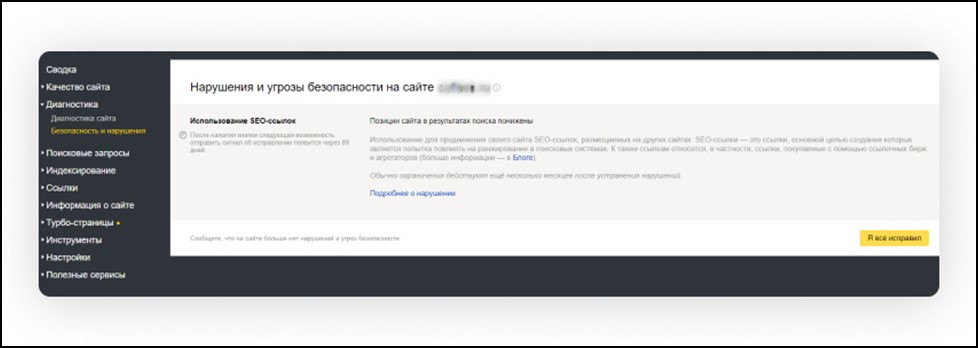

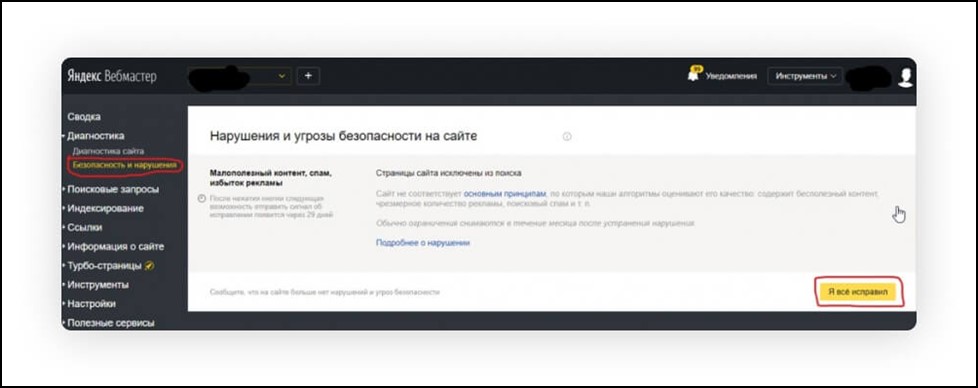

Чтобы узнать о нарушениях в Яндекс.Вебмастере открывают вкладку «Диагностика» → «Безопасность и нарушения».

В строку Яндекса вводят запросы, которые приводили трафик. При явном падении позиций вероятно попадание под фильтры. Также можно заказать проведение SEO-аудита специализированными агентствами. Подробнее рассмотрим фильтры и санкции Яндекса.

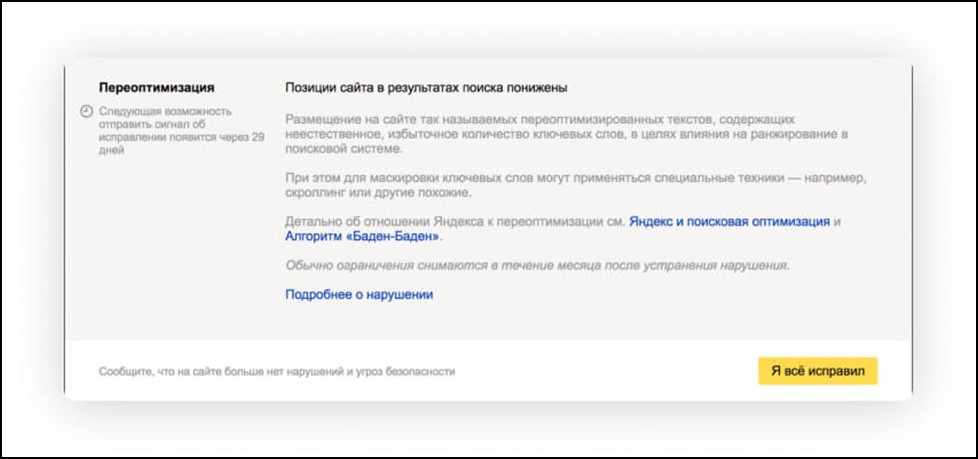

- «Баден-Баден» – фильтр против переспама, дублей и контента низкого качества.

Попадание под фильтр в Вебмастере выглядит так:

Как выйти из-под санкций: убрать проблемные тексты, переписать контент с учетом удаления лишних ключей, наполнить сайт уникальными и информативными текстами.

Фильтр после проверки поисковиком снимется примерно через месяц.

- «Минусинск» – фильтр по борьбе с некачественными ссылками с нерелевантных страниц.

Уведомление в Вебмастере:

Как выйти из-под санкций: провести анализ ссылок при помощи подходящего сервиса (например, PR CY), удалить покупные ссылки. Предоставить службе поддержки Яндекса список удаленных и существующих ссылок. В Вебмастере появится кнопка «проверить», которая запустит проверку и фильтр снимется, если все в порядке.

- Ссылочный взрыв – фильтр срабатывает при резком потоке ссылок в течение короткого времени.

Сайт попадет под санкции из-за большого количества поступающих ссылок, которые приобретены недобросовестными оптимизаторами.

Как выйти из-под санкций: проанализировать прирост ссылок и пояснить поддержке Яндекса причины прироста, если они не вызваны покупкой. Удалить некачественные ссылки и направить сайт на перепроверку.

- Непот-фильтр – накладывается за покупные и спамные ссылки. Фильтр игнорирует те ссылки, которые ему кажутся подозрительными, весь сайт не наказывает.

Как выйти из-под санкций: выявить ссылки с повторяющимися анкорами, убрать их и не приобретать ссылочную массу на непроверенных сайтах. Добавлять только те ссылки, которые ведут на тематические ресурсы.

- АГС – фильтр защиты от вредоносных сайтов.

Под санкции попадают ресурсы, которые продают личные данные пользователей, содержат вирусы, статьи сомнительного содержания, обманывающие посетителей.

Также под фильтр попадут сайты с искусственно созданным нечитабельным контентом, копипастом, накруткой трафика.

Как выйти из-под санкций: фактически переделать все содержание под правовые нормы и требования поисковиков. Этот жесткий фильтр может закрыть сайт навсегда.

- Аффилированность – фильтр, ограничивающий в выдаче сайты одного владельца с похожими запросами.

Сайты попадут под санкции, если имеют похожие домены, имеют одинаковые движки, ссылаются друг на друга, продвигаются по одним и тем же запросам и регионам.

Один из сайтов ограничивается в выдаче.

Как выйти из-под санкций: изменить CMS, хостинг, убрать перекрестные ссылки, одинаковые данные и тексты, сделать сайты разными по запросам для этого расширить тематику.

- Рекламный фильтр для борьбы с агрессивной и навязчивой рекламой.

Под санкции попадают сайты с баннерами, закрывающими контент, постоянно всплывающими окнами, шок-рекламой, избытком рекламы, недостоверной рекламой.

Уведомление в Вебмастере:

Как выйти из-под санкций: убрать навязчивую рекламу и ту, которая мешает читать тексты, удалить избыток рекламы.

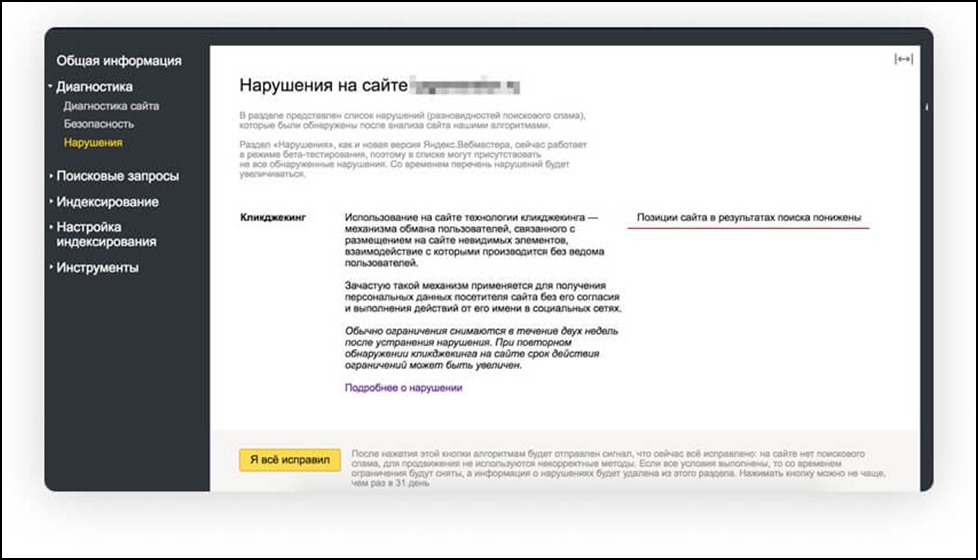

- Кликджекинг – фильтр против мошеннического приема. Техника кликджекинга позволяет уводить посетителя на заранее заданный сценарий. На сайте расположены невидимые элементы, которые могут закрывать экран или нужные объекты. Посетитель кликает на элемент и попадает на страницу подписки, репоста, рекламы.

Уведомление в Вебмастере:

Как выйти из-под санкций: удалить все невидимые элементы и скрипты, программирующие действия посетителя.

Важно: после всех исправлений сайт восстановит трафик через 1-2 месяца.

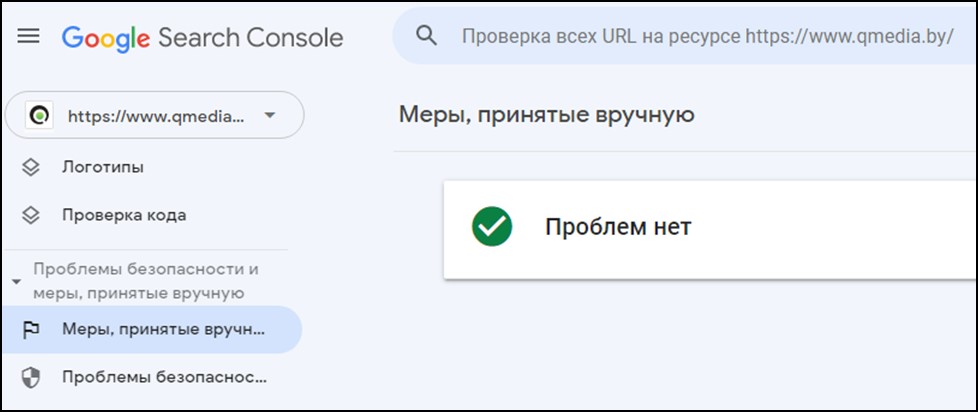

В Google Search Console для выявления ограничений нужно обратиться к разделу о «Проблемах безопасности и мерах», подразделу «Меры, принятые вручную». Там будет указана причина и рекомендации по устранению.

Фильтры Google:

- Panda: понижает рейтинг веб-сайтов с дублированным, плагиатным или некачественным контентом. Также касается сайтов с созданным пользователями спам-контентом и наполнением избыточными ключевыми словами.

- Penguin: понижает рейтинг сайтов с неестественными и некачественными ссылками со ссылочных ферм.

- Обновление полезного контента. Это обновление, выпущенное в 2022 году, предназначено для предоставления пользователям актуальной и полезной информации. Снижает позиции сайтов, которые публикуют контент только ради рейтинга в поисковых системах.

- Speed Update понижает в выдаче сайты с медленной загрузкой страниц.

Выход из-под санкций возможен после выполнения рекомендаций в Google Search Console.

Обновление поисковых алгоритмов

Алгоритмы поисковых систем постоянно развиваются, корректируя способы оценки и ранжирования сайтов на основе множества факторов, таких как использование ключевых слов, скорость сайта, удобство для мобильных устройств и многое другое. Например, обновление Google Mobile-First Indexing отдает приоритет сайтам, оптимизированным для мобильных устройств. Сайты, которые не адаптировались к этим изменениям и остались ориентированными на настольные компьютеры, увидели снижение рейтинга и органического трафика.

Нужно постоянно следить за обновлениями в официальных публикациях и применять предупреждающие действия:

- Регулярно проверять показатели сайта.

- Анализировать действия конкурентов, в частности, что они предпринимают при изменении алгоритмов.

- Создавать и тестировать гипотезы по оптимизации в период изменения алгоритмов.

Если вы будете опережать эти обновления и вносить необходимые коррективы в свою стратегию SEO, это поможет смягчить их влияние и предотвратить падение посещаемости сайта.

Внутренняя и внешняя ссылочная оптимизация

Внутренняя ссылка — это любая ссылка с одной страницы сайта на другую страницу. Пользователи и поисковые системы используют ссылки для поиска контента, навигации по сайту. Поисковые системы также используют ссылки для навигации. Они не увидят страницу, если на нее нет ссылок.

Существует несколько типов внутренних ссылок. Помимо ссылок на главной странице, в меню, в ленте публикаций и т. д., вы также можете добавлять ссылки в свой контент. Контекстные ссылки направляют пользователей на интересный и похожий контент. Более того, они позволяют поисковым системам определять, какой контент на сайте связан с ним и его ценность. Чем больше ссылок получает значимая страница, тем более важной она будет казаться поисковым системам.

Внешние ссылки ведут на значимые тематические страницы и подтверждают авторитетность сайта. Обратные ссылки — это, по сути, вотум доверия со стороны других сайтов. Они сигнализируют поисковым системам, что контент ценен и заслуживает доверия, что помогает улучшить рейтинг в результатах поиска.

Следует быть осторожными и не спешить в наборе ссылочной массы, в противном случае на сайт могут наложить санкции. Нельзя покупать ссылки на сомнительных ресурсах и пользоваться услугами непроверенных оптимизаторов.

Ухудшение поведенческих факторов

Если резко упала посещаемость сайта, дело может быть в ухудшении поведенческих факторов.

Поведенческие факторы представляют собой взаимодействие клиентов с сайтом. Эти взаимодействия включают внешние и внутренние факторы. Внешние – это поведение пользователей в поиске, клик по сниппету, прямые заходы, возвращение к поиску. Внутренние – продолжительность сессии, отказы, глубина просмотра.

Сайт с хорошими поведенческими характеристиками интересен поисковикам и повышается в выдаче. Ухудшение может произойти из-за:

-снижения качества содержания и мета-тегов.

-покупки кликов для имитации интереса пользователей и применения ботов для автоматического перехода из поиска.

За покупку кликов и применение ботов Яндекс применит поведенческий фильтр. Чтобы выйти из-под санкций, нужно устранить скрипты и ботов, не покупать клики, а заняться улучшением содержания сайта.

Сезонность товара или услуги

Если упала посещаемость сайта, причина может быть в сезонности. Сезонные колебания тесно связаны с тематикой сайта. Например, сайт, посвященный продаже новогодних украшений, увидит всплеск трафика в ноябре и декабре, но в январе он резко упадет. Это нормально и не обязательно является поводом для беспокойства, но следует учитывать это при анализе трафика. «История запросов» в Яндекс.Вордстате поможет выявить пики спроса.

Способы, помогающие избежать падения трафика в сезон:

- Предусмотреть акции и скидки в низкий сезон.

- Сформировать внесезонные предложения.

- Создать блог, где публиковать интересный людям SEO-оптимизированный контент.

Поменялся интент запроса

Падение посещаемости сайта может быть вызвано изменением актуальности запроса. Изменения в поведении пользователей, тенденциях или популярности определенных тематик или продуктов отрицательно повлияют на органический трафик.

Например, сайт, посвященный советам путешественникам, может столкнуться с уменьшением посещаемости из-за глобальных событий, таких как закрытие стран, из-за чего пользователи будут меньше искать туристическую информацию.

Также выдача по запросу может меняться с информационной на коммерческую и наоборот. За изменениями стоит следить, чтобы не потерять трафик.

Регулярное исследование ключевых слов и отслеживание отраслевых тенденций помогут предвидеть эти изменения и адаптироваться к ним.

Конкурентность

Если появляются новые конкуренты или существующие конкуренты улучшают свои стратегии SEO, они способны превзойти сайт в результатах поиска, что приведет к снижению видимости и падению органического трафика.

Конкуренция влияет на органический трафик из-за качества контента, тактики SEO и пользовательского опыта. Если конкурент начнет публиковать высококачественный контент, который точно соответствует популярным ключевым словам, он займет высокое место в результатах поиска.

Аналогичным образом, если у конкурента выше скорость сайта или лучше пользовательский интерфейс, он привлечет больше пользователей.

Необходимо регулярно анализировать поведение конкурентов, брать лучшие стратегии и постоянно заниматься улучшениями.

Подводим итог

Падение посещаемости сайта происходит по многим причинам: технических ошибок, проблем внешней и внутренней оптимизации, поисковых санкций, обновления алгоритмов, активизации конкурентов, ухудшения поведенческих факторов.

Самый эффективный способ привлечь и удержать органический трафик – это оптимизировать сайт для SEO. Как исправить снижение трафика:

- Провести анализ сайта и данных в Яндекс.Метрики и Google Analytics, проверить падение трафика и наличие санкций поисковых систем.

- Устранить технические проблемы.

- Оптимизировать контент на сайте: добавить уникальные тексты, устранить дубли, исправить мета теги.

- Провести внутреннюю и внешнюю ссылочную оптимизацию.

- Убрать навязчивую рекламу.

- Отслеживать изменения алгоритмов поисковых систем.

- Улучшать поведенческие факторы путем улучшения качества сайта.

- Отслеживать сезонность и поведение конкурентов.

Выяснив причины падения трафика, и приняв меры по исправлению ситуации, можно не только быстро восстановить потерянный трафик, но и увеличить его из-за проведенных улучшений.